آیا به اشتراک گذاری اطلاعات شخصی با چتبات بیخطر است؟

ممکن است برای کاربران وسوسه انگیز باشد که اطلاعات شخصی بهداشتی و مالی را در مکالمه با چتبات های مبتنی بر هوش مصنوعی فاش سازند. دلایل زیادی برای الزام محتاط بودن در این باره وجود دارند.

تصور کنید یادداشتهای خود را از یک جلسه با رادیولوژیست خود در یک چتبات مبتنی بر هوش مصنوعی قرار داده و از آن خواسته اید تا آن را خلاصه کند. پس از آن یک فرد غریبه از همان چتبات مبتنی بر هوش مصنوعی مولد درخواست میکند تا او را در مورد نگرانی هایش درباره سرطان آگاه سازد و برخی از مکالمههای ظاهرا خصوصی شما به عنوان بخشی از پاسخ به پرسش به آن کاربر ارائه میشود.

نگرانی در مورد بروز چنین مواردی از نقض احتمالی حریم خصوصی برای بسیاری از افراد بسیار مهم است، زیرا محبوبیت چتبات های مبتنی بر هوش مصنوعی مولد در حال گسترش است. پرسش بزرگ در اینجاست: آیا به اشتراک گذاری اطلاعات شخصی با این چتبات ها بی خطر است؟ پاسخ کوتاه این است که همیشه این خطر وجود دارد که اطلاعاتی که به اشتراک میگذارید به نحوی در معرض دید قرار گیرند با این وجود، راههایی برای محدود ساختن این خطر وجود دارند.

برای درک نگرانیها فکر کردن به نحوه آموزش این ابزارها مفید است این که چگونه در ابتدا حجم عظیمی از اطلاعات از اینترنت و منابع دیگر به آنها داده میشود و میتوانند به جمع آوری اطلاعات از تعاملات خود با کاربران ادامه دهند تا به طور بالقوه آنها را باهوشتر و دقیقتر سازند. در نتیجه، زمانی که از یک چتبات مبتنی بر هوش مصنوعی پرسشی را مطرح میکنید پاسخ آن تا حدی براساس اطلاعاتی است که شامل مطالبی میباشد که قدمت آن به مدتها قبل از وضع قوانین در مورد استفاده از دادههای اینترنتی و حفظ حریم خصوصی باز میگردد و حتی منابع جدیدتر مملو از اطلاعات شخصی افراد است که در سراسر وب پراکنده شده اند.

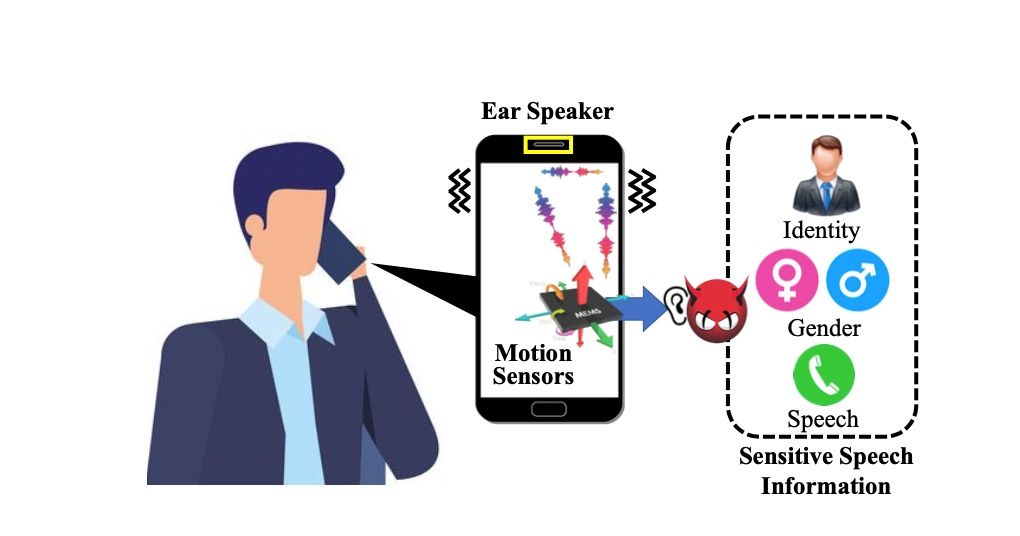

این امر فرصت زیادی را برای اطلاعات خصوصی به وجود میآورد تا در مواد آموزشی مختلف چتبات های مبتنی بر هوش مصنوعی مولد قرار گیرند اطلاعاتی که میتوانند ناخواسته در مکالمه شخص دیگری با یک چتبات ظاهر شوند یا به صورت عمدی توسط بازیگران بد از طریق درخواستها یا پرسشهای حیله گرانه هک یا فاش شوند. “رامایا کریشنان” مدیر دانشکده مرکز فناوری در دانشگاه کارنگی ملون میگوید:”ما میدانیم که چتبات ها بر روی حجم وسیعی از اطلاعات آموزش دیده اند که میتوانند حاوی اطلاعات حساس باشند و احتمالا حاوی این اطلاعات هستند”.

او اشاره میکند هنگامی که یک ابزار مبتنی بر هوش مصنوعی به کار گرفته میشود به طور کلی به آموزش تعاملات کاربران با آن ادامه میدهد و هر اطلاعاتی را که با آن تغذیه میشود جذب و ذخیره میکند. علاوه بر این، در برخی موارد کارکنان انسانی در حال خواندن برخی از مکالمات کاربران با چتبات ها هستند.

کارشناسان میگویند که این کار تا حدی برای تشخیص و جلوگیری از رفتار نامناسب و کمک به دقت و کنترل کیفیت مدلها و هم چنین برای تصمیم گیری در مورد این که شرکتها میخواهند هوش مصنوعی از کدام زیرمجموعه مکالمات برای آموزش استفاده کند صورت میگیرد.

- محتوی مرتبط:

- اولویتهای کلیدی تحول دیجیتال برای سال ۲۰۲۴

اتفاقاتی رخ میدهند

نگرانی در مورد حریم خصوصی صرفا در حد یک نظریه نیست. مواردی گزارش شده اند که نشان میدهند اطلاعات محرمانه به طور ناخواسته در اختیار کاربران قرار گرفته اند. در مارس گذشته Open AI آسیبپذیریای را فاش ساخت که به برخی از کاربران چتبات چت جی پی تی (Chat GPT) اجازه میداد عناوین چتهای کاربران دیگر با آن ابزار مبتنی بر هوش مصنوعی را ببینند و هم چنین ممکن است به طور خلاصه اطلاعات مربوط به پرداخت برخی از کاربران از جمله آدرسهای ایمیل و چهار رقم پایانی شماره کارت اعتباری آنان و هم چنین تاریخ انقضای کارت را در معرض نمایش قرار دهد. این رخداد در نتیجه یک اشکال در برخی از نرم افزارهای منبع باز بود.

نگرانیهای مربوط به حریم خصوصی به اندازهای بزرگ هستند که چندین شرکت استفاده از چتبات های مبتنی بر هوش مصنوعی توسط کارمندان خود در محل کار را محدود یا ممنوع ساخته اند. رایکو میگوید: “اگر شرکتهای بزرگ نگران حریم خصوصی خود هستند این به ما میگوید که هنگام به اشتراک گذاری هر چیز شخصی باید محتاط باشیم”. رایکو میگوید در مورد آن چه که پیشتر در مدلهای چتبات وجود داشته کار زیادی نمیتوان انجام داد.

فقط این کار را انجام ندهید

سازندگان چتبات ها اقداماتی را برای محافظت از حریم خصوصی کاربران انجام داده اند. برای مثال، کاربران میتوانند توانایی چت جی پی تی برای ذخیره تاریخچه چت خود را به طور نامحدود از طریق گزینهای قابل مشاهده در صفحه اصلی آن خاموش و غیر فعال سازند. این یک محافظت بی خطر در برابر هکرها نیست و کماکان چتهای جدید کاربرانی را که این گزینه را انتخاب میکنند به مدت ۳۰ روز ذخیره میشوند. با این وجود، از آن چتها برای آموزش مدل استفاده نمیشود. بارد (Bard) چتبات مبتنی بر هوش مصنوعی ساخته شده توسط گوگل از کاربران میخواهد که وارد Bard.Google.com شوند سپس چند مرحله را برای حذف تمام فعالیتهای چت بهعنوان پیش فرض دنبال کنند.

کاربران بینگ (Bing) چتبات مبتنی بر هوش مصنوعی ساخت مایکروسافت نیز میتوانند صفحه وب چتبات را باز کنند، تاریخچه جستجوی خود را در سمت راست صفحه مشاهده کنند و سپس چتهای فردی را که میخواهند حذف شوند حذف نمایند. یکی از سخنگویان مایکروسافت میگوید: “با این وجود، کاربران در حال حاضر نمیتوانند تاریخچه چت را غیرفعال کنند”.

کارشناسان میگویند بهترین راه برای محافظت از خود آن است که کاربران از به اشتراک گذاری اطلاعات شخصی با ابزار هوش مصنوعی خودداری کنند و هنگام مکالمه با هر چتبات مبتنی بر هوش مصنوعی اصطلاحا به دنبال پرچمهای قرمز خاص یا علامتهای هشدار دهنده باشند. برخی از پرچمهای قرمز شامل استفاده از چتبات هایی است که هیچ گونه اطلاعیهای درباره حفاظت از حریم خصوصی کاربران ندارند. این به شما میگوید آن چتبات چندان امن نیست.

مورد دیگر زمانی است که یک چتبات اطلاعات شخصی بیش تری از آن چه منطقی و ضروری به نظر میرسد را از شما درخواست میکند. گاهی اوقات برای ورود به یک حساب کاربری باید شماره حساب یا رمز عبور خود را به اشتراک بگذارید و به برخی از سوالات شخصی پاسخ دهید این موضوعی غیر عادی نیست، اما گاهی از شما خواسته میشود تا شماره مرتبط با دریافت خدمات اجتماعی خود را به اشتراک بگذارید که امری متفاوت است و نباید این کار را انجام دهید. هم چنین، عاقلانه نیست که با یک چتبات در مورد چیزی که تاکنون درباره آن نشنیده اید صحبت کنید، زیرا کل سیستم ممکن است توسط بازیگران بد اداره شود.

منبع: فرارو به نقل از وال استریت ژورنال